本文刊发于《现代电影技术》2023年第1期

专家点评

虚拟化制作是影视、游戏、直播等领域的新兴内容制作手段,而数字人和虚拟角色的制作与控制则是虚拟化制作的焦点内容。如何让数字人和虚拟角色表现得真实自然,除了精细的外形,更重要的是虚拟角色的动作要流畅自然。解决数字人动作问题的传统方式是通过基于光学、惯性、电磁等捕捉原理的动作捕捉技术,让数字人获得接近真人的动作,但是流程复杂、周期长、成本高。《基于三维姿态估计的虚拟角色运动控制方法》一文将人工智能动作提取与游戏引擎实时交互相结合,借助三维姿态估计算法,基于视频影像提取动作数据并驱动虚拟角色,提出了一种低成本数字人和虚拟角色的动作解决方案。文章从动作视频筛选、三维动作数据提取、虚拟角色制作、虚拟角色动作控制等方面阐述了技术流程及操作方法,设计了虚拟角色运动控制实验,验证了方法的可行性和优缺点。本文对当前虚拟化制作领域的数字人和角色运动控制进行了积极的探索,期待未来研究成果不断成熟完善,广泛服务于数字内容制作领域。

——陈军

研究员

北京电影学院影视技术系主任

作 者 简 介

北京电影学院中国电影高新技术研究院2020级硕士研究生,主要研究方向:数字电影技术、虚拟现实。

杜昊昊

韩菲琳

北京电影学院影视技术系硕士生导师,主要研究方向:数字电影技术、虚拟现实。

摘要

随着虚拟制作在电影、游戏、直播等各个领域的广泛应用,虚拟角色控制方法成为当前研究热点之一。本文将人工智能动作提取与游戏引擎实时交互相结合,研究一种更加高效的虚拟角色运动控制方法,借助三维姿态估计算法,基于视频影像提取动作数据,将其与虚拟角色绑定,实现实时动作驱动,并通过实验梳理了使用流程及操作要点。该方法不依赖于价格高昂的动作捕捉设备,操作便捷、成本低廉,能够有效服务于虚拟预演等应用场景。

关键词

虚拟角色 运动控制 三维姿态估计 动作捕捉

1引言

虚拟角色运动控制在动画、电影、电视剧、舞台表演等方面发挥着重要作用。近年来,虚拟角色在演唱会、直播、社交媒体等领域的广泛应用,也为其创造了移动互联网等众多新的应用场景和需求。后疫情时代线上社交、XR演唱会、VR、AR、元宇宙等产业飞速发展,虚拟人的应用场景日益丰富。虚拟角色运动控制涉及虚拟角色建模、动作捕捉、三维扫描、计算机视觉等,服务于展现流畅、自然的虚拟人动作,制作丰富、多样的虚拟人动画,具有十分重要的研究意义。

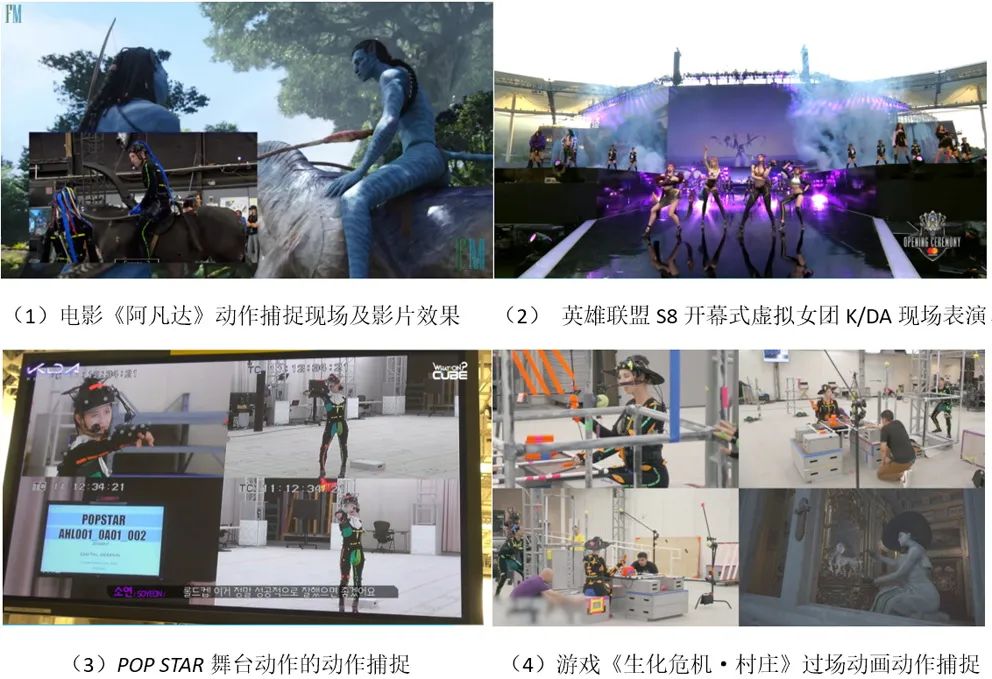

图1 动作捕捉在影视制作中的应用示例

传统的动作捕捉系统在电影、游戏、舞台直播等各方面均有较为成熟的运用,适合动作精度要求高、表演细节丰富的应用场景。图1(1)为2009年上映的电影《阿凡达》,通过在演员、马匹及道具上粘贴标记点,实现虚拟角色的动作捕捉,并结合虚拟拍摄系统实现虚拟角色的实时监看;图1(2)为游戏《英雄联盟》的衍生虚拟女团K/DA,在英雄联盟2018年赛季全球总决赛开幕式舞台上,以AR形式与真人歌手同场登台演唱歌曲POP STAR,图1(3)为真人替身演员为POP STAR的现场表演进行动作捕捉数据采集;图1(4)为游戏《生化危机·村庄》,借助真人表演捕捉来制作游戏过场动画,以期达到恐怖逼真的视觉效果。当虚拟角色造型或表演需要夸张时,也常由动画师在三维软件中制作动画,如游戏《马里奥的折纸王国》中玩家控制的虚拟角色,其动作来自动画师制作的角色动作库,再借助引擎实现玩家交互式运动控制等。

影视级动作捕捉系统通常需要演员在动作捕捉摄影棚中表演并穿戴专业设备,价格十分昂贵,而且空间受限。当影视作品涉及大量虚拟角色群戏场景时,如动作相似且规模庞大的战斗场面,其群演群体动作的获取,若采用动作捕捉方案,耗费人力物力;若由动画师制作,则需较长工期;若采用程序化动作生成,其生成结果往往不够真实自然。随着元宇宙产业的发展,虚拟角色动作驱动的需求也下沉到更多移动端用户,常可见于QQ秀、淘宝虚拟客服等功能,在移动端开放用户可自选的动作库。因此提出成本更为低廉、数据获得更为便捷但同样可以达到效果需求的动作捕捉方案具有广阔的应用空间。

随着计算机图形学、深度学习的发展,从图像或视频中获取能够驱动虚拟角色数据信息的技术方法越来越丰富,三维姿态估计作为一种更为高效、易操作、成本低廉的动作捕捉方案,使得上述设想成为可能。本文基于上述的行业需求以及目前虚拟人建模、动作捕捉的技术现状提出了一种基于三维姿态估计的虚拟角色运动控制方法。

2相关工作

2.1 虚拟角色建模方法

虚拟角色的驱动实验首先需要获取虚拟角色模型,目前对于虚拟人的建模制作有多种方式,较为常用的建模类型有:基于三维软件的创作型建模;基于三维扫描设备的捕获型建模;基于二维图像的拟合型建模;基于数据库及数字人编辑器的参数化建模。[1]

本实验中采用的虚拟角色建模方式,是基于数据库和数字编辑器的参数化建模。此方法需建立一个包含各个人体部位的数据库,包含不同形体的人体模型和各类人体部位。通过查找最近似的人体模型预设,编辑、调整和修改各部位参数,从而得到一个定制化三维人体模型。目前此类方法最常用的工具有MetaHuman Creator、Character Creator 3、Daz 3D等。此类方法依赖于用户的观察力和经验,以及工具的参数化程度,参数化程度低会影响用户修改人体模型的自由度,参数化程度高会需要大量时间修改参数且依赖用户的制作经验。

MetaHuman Creator为目前较为广泛使用的工具之一。首先通过扫描得到大量的真实人类面部信息,通过人工智能和机器学习处理数据,提取出每个角色的特征点信息,以DNA数据格式存储,用于描述角色的外观、骨骼绑定。借助Unreal Engine(UE)的GenePool数据库,将用户的捏脸交互操作,转换为在GenePool数据库中进行检索与混合,避免了传统捏脸算法的几何约束计算,能够在较短的时间内制作出更真实自然的人脸模型,大大降低用户操作门槛。基于用户捏好的数字角色,也会生成一份独一无二的DNA数据。该工具采用像素流送(Pixel Streaming)技术在云端服务器上运行UE应用程序,通过WebRTC将渲染的帧和音频流送到浏览器和移动设备,在云端UE中制作的数字人也能够导出到本地UE中使用,大大降低了用户的硬件门槛,真正实现所见即所得[2]。

2.2 虚拟角色动作捕捉方法

动作捕捉技术最早起源于动画领域,随着科技的发展,动作捕捉的技术手段越来越丰富且在电影、游戏、VR等各行各业均有十分广泛的应用。目前已发展出多种多样动作捕捉解决方案,根据输入方式的不同,可以分为基于外设捕获运动数据的方式,如使用视觉传感器和惯性传感器的方法,以及基于内在生理视觉数据的时序性识别方案。在使用外设的动作捕捉技术中,根据设备检测方式的不同,可以分为光学式和惯性式;在可穿戴式人体动作捕捉方法中,根据传感器的不同,可以分为基于IMU(Inertial Measurement Unit)惯性传感器、RGB摄像头、深度摄像头或红外传感器等[3]的动作捕捉方法。

本实验中使用的虚拟角色三维姿态估计的方法则是基于计算机视觉的动作捕捉方法。根据数据来源不同可分为:基于深度图像的方法、基于红外图像的方法、基于RGB彩色图像的方法以及基于多模态数据融合的方法。根据图像采集方式可分为:基于单目视觉、基于双目视觉和基于多视图融合。对于单目视觉人体动作数据获取方法,按照算法处理过程可分为:二步法、直接法、端到端等[4]。随着移动端的发展和短视频时代的到来,实现了不受场地和设备限制的动作捕捉方式。基于单目图像的二维姿态估计技术相对成熟,对于三维姿态估计而言,缺少深度信息,从单目视觉信息恢复人体三维姿态具有不确定性和任意性,较难直接得到关节之间的转换矩阵等运动信息,人体骨骼关节点解算需进行一定的假设和逆向运动学求解。同时对于动作数据的提取,需要完成动作的时序性建模与识别,才能提取出连贯的动作信息。本文选取DeepMotion方法参与三维人体姿态估计,用于从视频数据中获取三维动作数据。

3实验方法

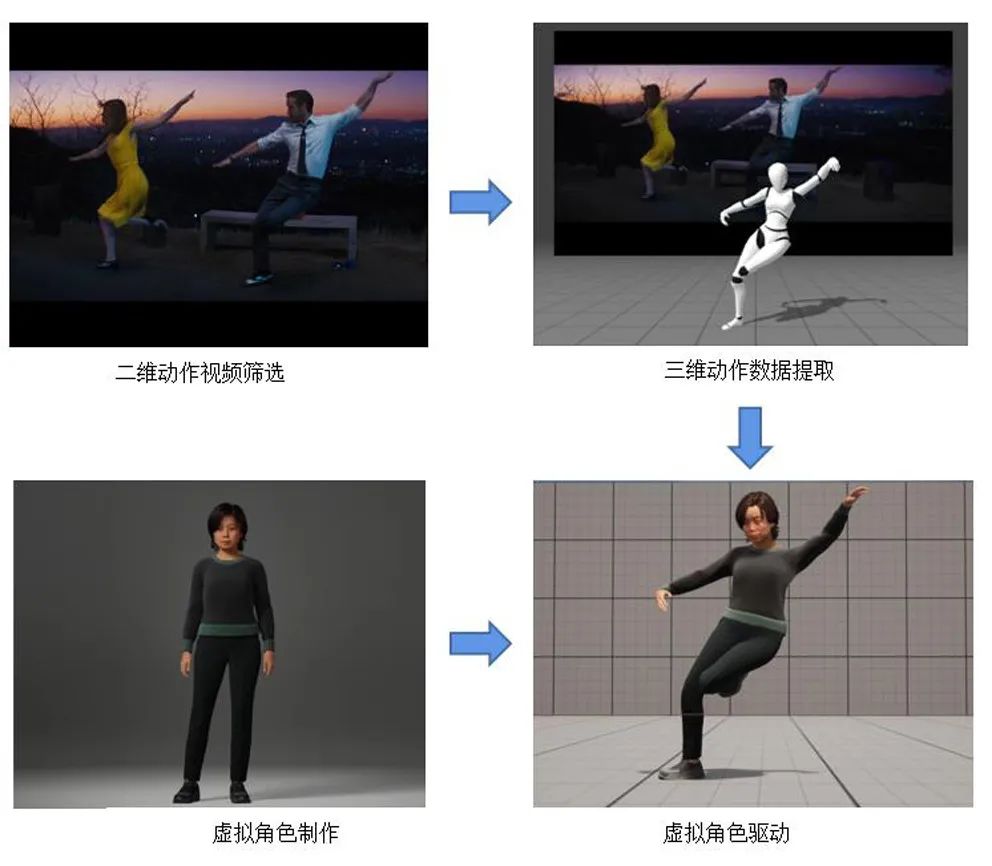

该实验流程主要包括:二维动作视频筛选、三维动作数据提取、虚拟角色制作、虚拟角色驱动,如图2所示。首先筛选视频源,选取清晰且包含人体运动的片段,用于三维动作数据提取,然后借助三维姿态估计工具进行分析解算,将得到的三维动作数据映射到目标虚拟角色已绑定的骨骼结构,以实现虚拟角色的动作驱动。在此实践方案中我们采取DeepMotion作为三维姿态估计工具,采用MetaHuman Creator生成目标虚拟角色,最后在UE5中完成动作的重定向实现虚拟角色的动作驱动。

图2 基于视频的虚拟角色动作驱动方法

3.1 三维动作数据提取工具

目前,基于视频的动作提取工具主要有DeepMotion的Animate 3D、PixCap、Plask、RADICA、ThreeDPoseUnityBarracuda、CMU OpenPose、Vibe等,本文获取三维动作数据主要采用DeepMotion的Animate 3D功能。DeepMotion基于AI技术,实现从二维视频获取BVH/FBX格式的三维动作数据,可用于虚拟角色模型运动重定向并生成三维虚拟角色动画,能够实现物理模拟、足部固定、变速控制、全身动作及面部手部动作追踪等功能。DeepMotion提出了一种基于轨迹优化、深度增强学习的高效处理流程,能够对包括胯下运球、交叉运球等各类运球方式进行鲁棒性较高的学习和动作控制[5]。目前在DeepMotion平台上也开放了手部动作数据的检测提取功能。

图3 DeepMotion操作界面

对于DeepMotion而言,想要得到最优的动作质量,对人体动作视频源素材有以下几点要求:(1)视频拍摄机位需固定且平行于拍摄人物;(2)全身或从头部至腰部的上半身应清晰可见,在距摄影机2~6米的距离最佳;(3)与背景有强对比的中性光照条件为佳;(4)被摄人物应不被任何物体遮挡,同时应在视频片段中只有一名人物;(5)不要穿着会遮挡膝盖、手肘等关键关节的宽松衣物;(6)对于脸部、手部的追踪在仅有上半身的模式最佳。因此在进行视频信息的输入时,便需要进行一定的筛选。如图3所示,筛选后的视频上传后根据输出需要进行处理方式的选择,最后进行三维动作生成。如图3为DeepMotion的操作界面,可根据动作数据提取的需要进行相应的设置,包括输出格式的设置(选定BVH、FBX、MP4等),骨骼根节点设置(确保在UE5中骨骼的复用),物理过滤设置(使运动解析结果更加平滑稳定),面部、手部的动作捕捉,是否只有上半身等。在本次实验中我们采取如图3所示的参数设置,在进行对视频动作的解析前,会进行参数设置的确认。

为验证本文方法的有效性,我们设计了虚拟角色运动控制实验,采用了经典电影的动作片段、个人拍摄动作片段、学生电影短片动作片段等作为视频源进行动作提取。在实验前期获取视频素材时,个人拍摄的动作片段较为容易满足上述条件。成片电影中,往往需要通过非线性编辑展现丰富的拍摄手法,借助视听语言表达其视觉艺术特性,只有较少量视频素材满足上述要求,若需应用在电影拍摄中,应当架设专门的机位用于动作捕捉。对于舞台表演来说,通常有记录单人舞台的直拍素材,非常适合使用此类动作捕捉流程。

3.2 虚拟角色制作

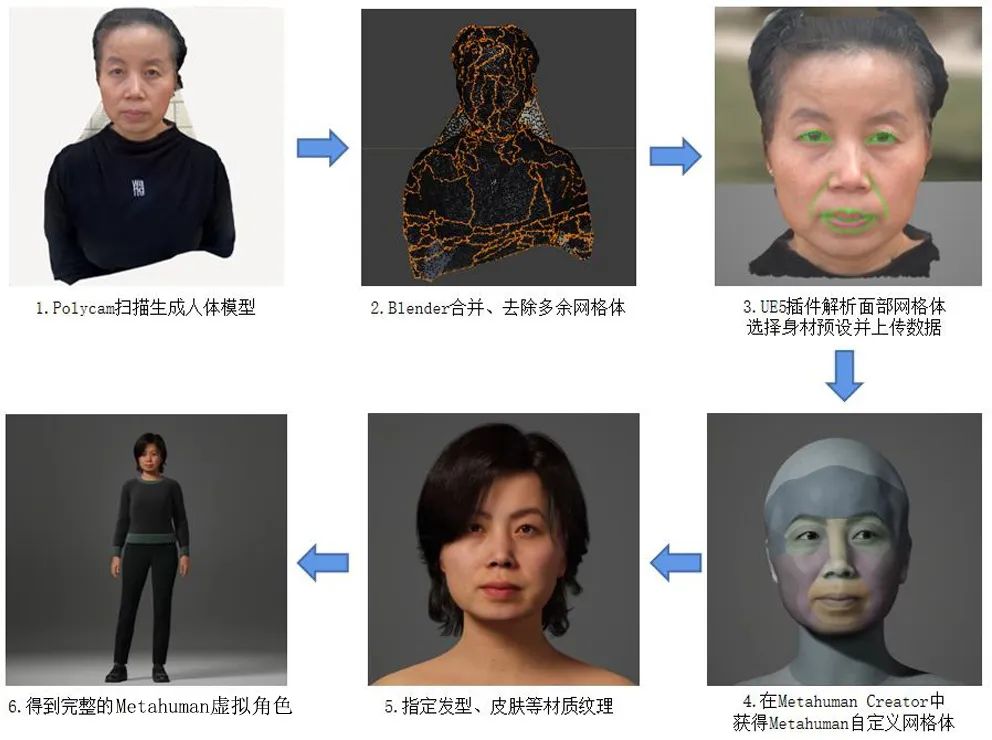

本实验的虚拟角色使用MetaHuman Creator进行制作。在MetaHuman Creator中创建虚拟角色,既可以直接采用预设对虚拟角色进行面部修改,也可以采取本实验应用的Mesh to MetaHuman方法得到自定义的虚拟角色。头部网格体借助Polycam照片采集方法,获得真实人物的头部模型。

本文采用的虚拟角色制作流程如图4所示。首先,通过Polycam采集真实人物照片,并得到人物头部模型的初步结果。在进行照片扫描时需注意以下事项:(1)保证五官清晰可见,无杂乱的毛发遮挡,额头的碎发会影响后续MetaHuman面部网格体的生成;(2)选择光线均匀柔和的光源环境;(3)每张相邻的照片保证有50%以上相同的特征点;(4)Polycam至少需要采集20张才可进行处理。Polycam处理照片得到的模型如图4中第二步,系多个网格体的拼接结果,存在部分杂乱的背景网格体,会对后续的数据解析造成干扰。因此,在第二步,需要将得到的网格体使用Blender进行预处理。第三步,将处理后的头部网格体导入UE5中,使用插件对其进行MetaHuman的本体解算和Mesh转MetaHuman。第四步,在MetaHuman Creator中预览MetaHuman的自定义网格体,并对面部细节进一步调整。最后,使用MetaHuman Creator指定虚拟角色的发型、皮肤、服装等纹理和材质,生成完整的虚拟角色模型,其自带的骨骼绑定可以直接用于动作重定向。

图4 虚拟角色制作示意图

3.3 虚拟角色运动控制

通过在UE5中重定向的方式,将DeepMotion提取出的三维动作数据映射到MetaHuman骨骼,实现完整的虚拟角色驱动流程。该重定向步骤如图5、图6所示,在UE5中由IK绑定(IK Rig)和IK重定向器(IK RTG)来实现。

图5 虚拟角色IK Rig骨骼序列

实现动作重定向,设置DeepMotion提取得到的动作骨骼作为源IK Rig,以及MetaHuman的骨骼链作为目标IK Rig,需保证两者IK Rig的骨骼链完全一致,实现关节点的一一对应,如图5所示。本实验中应用的IK Rig以骨盆处的关节点为根节点,包含root、Head、Spine、ArmLeft、ArmRight、LegRight、LegLeft共7条重定向链,18个关节点。在重定向器中(图6)指定源IK Rig和目标IK Rig。由于MetaHuman的初始姿态为A-pose,需在映射前将其调整为与源骨骼一致的T-pose,在资产浏览器中将源IK Rig的动画序列导出为目标IK Rig的动画序列,即可得到MetaHuman的动画序列资产。在UE5中有多种驱动虚拟角色运动的方式,如动画蓝图、状态机等,本实验使用Sequencer给虚拟角色添加动画轨道,以实现虚拟角色的动作控制。

图6虚拟角色IK重定向器界面

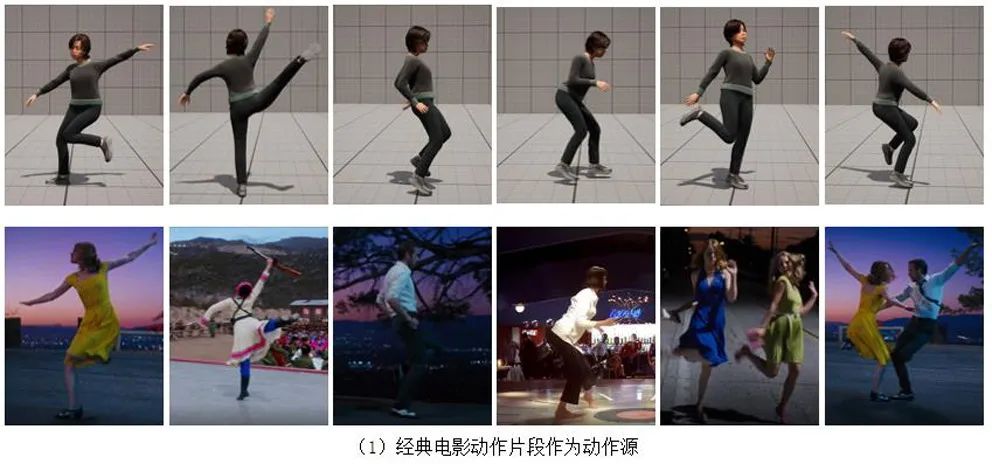

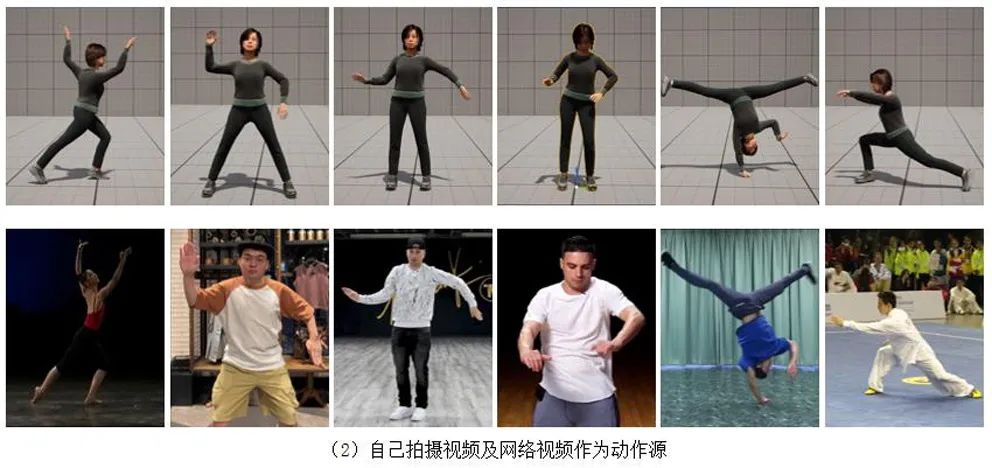

本实验选取12段时长在5~20s的视频,共4024帧动作数据,用作三维动作数据提取。在视频的选取时,应尽量遵循3.1所述的要求。视频来源包括:经典电影作品《爱乐之城》《芳华》《低俗小说》等出现的舞蹈动作、网络视频以及实验拍摄的固定镜头视频。视频素材使用分辨率为1920×1080,电影素材帧率24FPS,实验拍摄及网络视频素材帧率为30FPS,对虚拟角色的驱动效果如图7所示。

图7 虚拟角色运动控制结果示意图

实验结果表明使用此方法可以满足绝大多数情况下在虚拟角色上复现视频动作的需求,但也存在一定问题。测试表明,相较于一段20s舞蹈动作片段,将其分割为短动作片段(如5s左右),会具有更好的动作识别效果。通过分析虚拟角色运动控制实验结果,本文发现,舞蹈动作中裙摆的摆动对动作识别有一定干扰。在存在两个人物的视频中,当人体动作没有被遮挡且镜头较为稳定时,同样可以识别得到较优的动作效果,但只能识别单人人物动作,被识别的人物是随机的。由于实验拍摄和网络视频,较容易满足镜头稳定、全身、与背景对比度相对较高、关节清晰等要求,因此选取了几段高难度舞蹈动作片段,实验结果表明,夸张四肢动作识别效果较好。对于涉及灵活的手腕和脚踝局部动作,识别效果较差,容易出现局部扭动等违反运动规律的变形,在动作平滑度和连续性方面,也会存在关节跳变。运动过程中若存在肢体交叉,容易出现前后关系的误判,人体旋转时也会偶有漂移和抖动,若将视频源帧率降低会得到更准确的识别结果。

4总结与展望

本文提出了一种基于三维姿态估计的动作数据提取方法,并实现虚拟角色的运动控制,从动作视频筛选、三维动作数据提取、虚拟角色制作、虚拟角色动作控制等方面,阐述了技术流程及操作方法。本文设计了虚拟角色运动控制实验,选取12组测试动作样片的4024帧人物运动帧,提取动作数据,并对虚拟角色运动控制方法进行验证。实验结果表明,该方法能够一定程度满足应用需求,相较于传统的运动捕捉技术具备操作便捷、成本低廉、对空间不设限等优点,十分适合在移动端和预演场景的应用。

目前此方法仍存在不足,获取的动作在精度、自然度、流畅度、稳定性都有待进一步提高,仍无法满足影视级虚拟替身动作控制的需求。未来,随着基于单目图像的三维姿态估计方法的能力提升,精度更高、速度更快的动作捕捉方法,将会大幅拓宽该方法的应用场景,在直播、影视、游戏、交互、VR等更多领域达到降本增效的效果。

参考文献

(向下滑动阅读)

[1]任利锋. 虚拟环境中的虚拟人技术研究[D].浙江大学,2008.

[2]腾讯游戏学堂. Metahuman原理及流程浅析[EB/OL]. http∶///p/445646111.2022.

[3]周瑞文. 基于惯性测量单元的三维动作捕捉系统关键技术研究[D].哈尔滨工业大学,2020.

[4]李超. 基于卷积神经网络的人体行为分析与步态识别研究[D].浙江大学,2019.

[5]Liu L, Hodgins J. Learning basketball dribbling skills using trajectory optimization and deep reinforcement learning[J].ACM Transactions on Graphics (TOG), 2018, 37(4): 1-14.

【本文项目信息】北京市自然科学基金青年项目《基于多视图学习的无标记点三维动作捕捉关键技术研究》(4214073)。

主管单位:国家电影局

主办单位:中央宣传部电影技术质量检测所

刊号:CN11-5336/TB

标准国际刊号:ISSN 1673-3215

投稿邮箱:

官方网站:

广告合作:

期刊发行:

发表评论